Сборка кластера на Centos 7 с использованием распределённого реплицируемого блочного устройства DRBD

В этой статье мы соберем кластер на дистрибутиве Centos 7 с использованием пакета Pacemaker. Сборка из исходников DRBD описывается в этой статье. Настройка реплицируемого блочного устройства описывается в статье по этой ссылке. Для полноценной работы кластера одного DRBD не достаточно, должен быть механизм мониторинга состояния блочных устройств, процессов, сервисов, состояние работы самой операционной системы, сети […]

В этой статье мы соберем кластер на дистрибутиве Centos 7 с использованием пакета Pacemaker.

- Сборка из исходников DRBD описывается в этой статье.

- Настройка реплицируемого блочного устройства описывается в статье по этой ссылке.

Для полноценной работы кластера одного DRBD не достаточно, должен быть механизм мониторинга состояния блочных устройств, процессов, сервисов, состояние работы самой операционной системы, сети ит.д. Также должен быть механизм репликации диска на другую ноду в случае отказа первой. Также в некоторых случаях используется один общий виртуальный ip адрес на нодах для возможности функционирования кластера как единая система. Этими функциями DRBD не занимается.

Вышеописанными задачами занимается Pacemaker – менеджер ресурсов кластера.

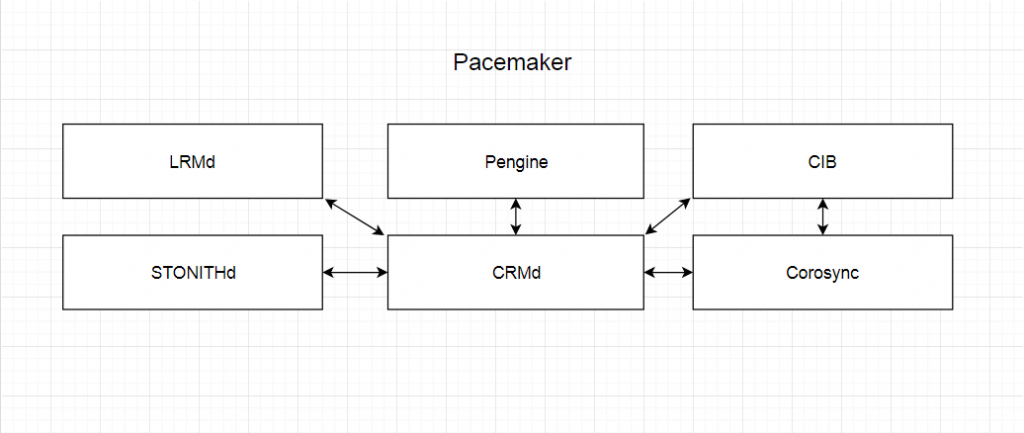

Pacemaker состоит из 5 ключевых компонентов:

- CIB – Cluster Information Base это база данных которая содержит конфигурацию кластера и состояние ресурсов кластера. Сама база данных храниться в файле в формате XML

2. Stonithd – это механизм, который позволяет кластеру выключать, перезагружать, включать узлы кластера сети если узел не отвечает, то его ресурсы передаются другой ноде, или если ресурс дал сбой он отключается от общего кластера для предотвращения сбоя всего кластера.

3. PEngine – механизм политики. Он рассчитывает идеальное состояние кластера. Если какой либоо механизм дал сбой, PEngine сделает перерасчет механизма работы всего кластера и передаст его в CRMd

4. CRMd – демон управления ресурсами кластера. PEngine выбирает CRMd на какой-то одной ноде. В случае сбоя забочей ноды с CRMd быстро назначается новая нода как главная. Главная CRMd получает инструкции от PEngine и передает их в требуемом порядке или LRMd (демон локального управления) или одноранговым CRMd на других нодах, а те в свою очередь LRMd своего локального процесса.

5. LRMd – демон управления локальными ресурсами который исполняет полученные инструкции от CRMd на локальной машине, а также передает обратно результат их выполнения.

Для правильной работы кластера нам необходимо иметь по 2 сетевых интерфейса в каждой ноде. По первому интерфейсу будет связь с общей сетью, а через второй интерфейс ноды будут обмениваться служебной информацией.

Также нужно настроить имя хостовой машины и DNS для общения серверов по имени

Исходные параметры первой ноды

Первый интерфейс 192.168.32.20 (доступ в локальную сеть)

Второй интерфейс 10.10.10.1 (интерфейс для общения нод)

Имя хоста ha1

Исходные данные второй ноды:

Первый интерфейс 192.168.32.19 (доступ в локальную сеть)

Второй интерфейс 10.10.10.2 (интерфейс для общения нод)

Имя хоста ha2

Для изменения имени хоста без перезагрузки сервера воспользуемся утилитой hostnamctl

# hostnamectl set-hostname ha1 – выполняем на первой ноде.

# hostnamectl set-hostname ha2 –выполняем на второй ноде.

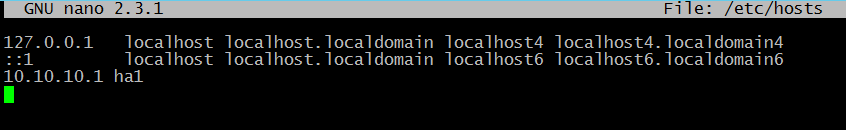

После указания имени хоста необходимо в файле /etc/hosts прописать Ip адрес и hostname противоположных атс.

На первой ноде добавляем

10.10.10.2 ha2

На второй ноде добавляем

10.10.10.1 ha1

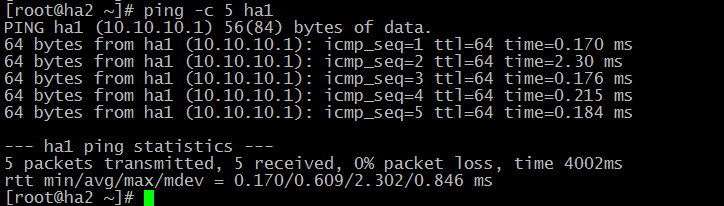

Далее необходимо проверить корректность введенных данных пропинговав друг друга по имени хоста.

# ping ha1 – на второй ноде

# ping ha2 – на первой ноде

Результат должен быть как на скриншоте (пример с одной ноды):

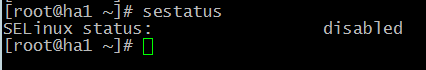

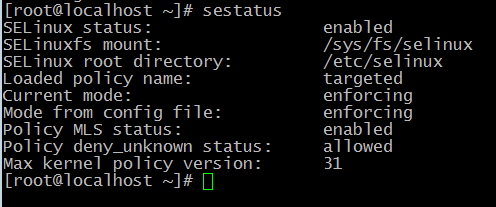

Перед наxалом установки убедитесь, что отключен SELINUX

Если Selinux включен, отобразится следующее сообщение:

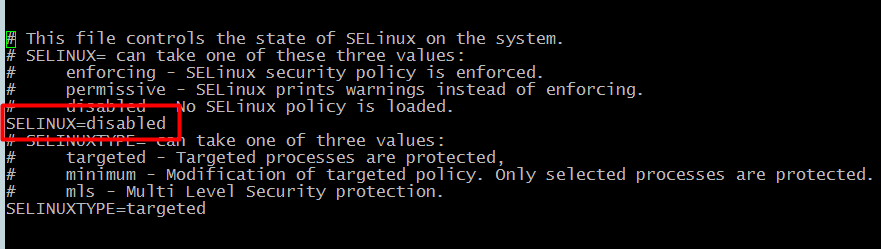

Для выключения Selinux необходимо в конфигурационном файле /etc/selinux/config прописать SELINUX=disabled

Далее приступим к установке необходимых пакетов для сборки кластера:

# yum install –y pacemaker pcs resourse-agent corosyncГде pacemaker описан выше, менеджер ресурсов кластера. Он позволяет использовать службы и объекты в рамках одного кластера из двух или более нод.

Resource-agent – этот пакет содержит агенты ресурсов(набор скриптов) кластера (RA), соответствующие спецификации Open Cluster Framework (OCF), используемые для взаимодействия с различными службами в среде высокой доступности, управляемой менеджером ресурсов Pacemaker.

Corosync – информационный уровень. программный продукт, который позволяет создавать единый кластер из нескольких аппаратных или виртуальных серверов. Corosync отслеживает и передает состояние всех участников (нод) в кластере.

Этот продукт позволяет:

- мониторить статус приложений;

- оповещать приложения о смене активной ноды в кластере;

- отправлять идентичные сообщения процессам на всех нодах;

- предоставлять доступ к общей базе данных с конфигурацией и статистикой;

- отправлять уведомления об изменениях, произведенных в базе.

Pcs – pacemaker/corosync configuration system. Утилита для управления, настройки и мониторинга кластера. Управляется как через командную строку, так и через веб интерфейс.

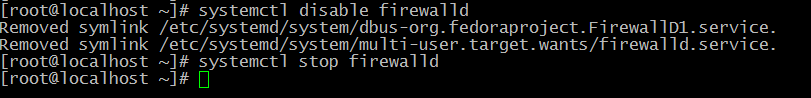

На следующем этапе необходимо отключить фаервол на время, после сборки кластера в фаевол надо обязательно включить и прописать необходимые порты.

# systemctl stop firewalld

# systemctl disable firewalld

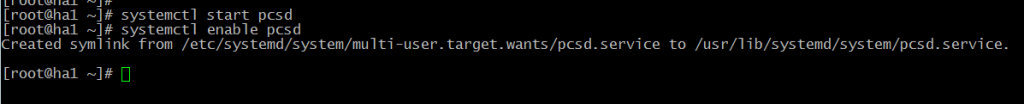

На следующем этапе запустим на обеих нодах pcs демон:

# systemctl start pcsd

# systemctl enable pcsd

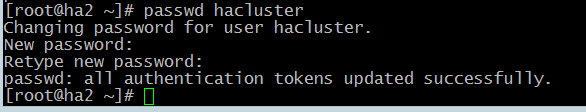

После установки pcs на обоих нодах будут созданы пользователи «hacluster»

С помощью этих учеток ноды будут «общаться между собой». Зададим для них новые сложные пароли:

# passwd hacluster

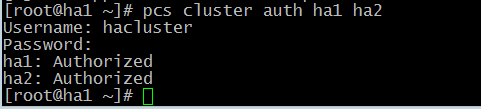

Далее с помощью pcs авторизуемся на обоих нодах:

# pcs cluster auth ha1 ha2После удачной авторизации выведется следующее сообщение:

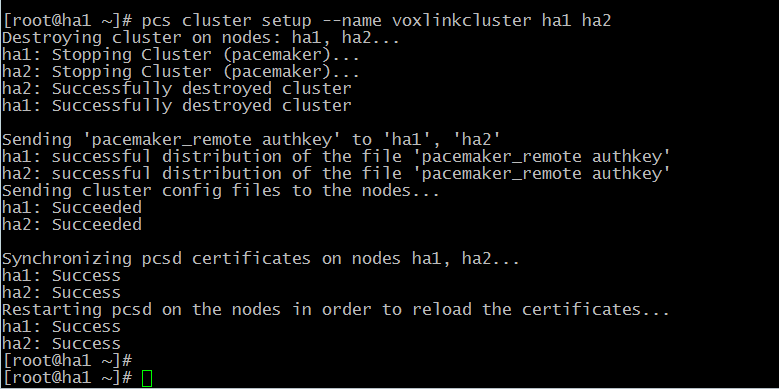

На следующем шаге создаем кластер:

# pcs cluster setup –name voxlinkcluster ha1 ha2Эта команда создаст кластер, автоматически сгенерирует конфигурационный файл corosync.

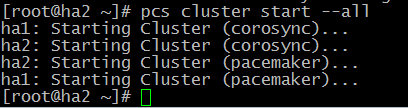

После успешного создания кластера его необходимо запустить следующей командой:

# pcs cluster start –all

Как видно из скриншота, запускается corosync и pacemaker.

На этом установка и первоначальная настройка кластера завершена. В следующей статье мы поговорим про управление, мониторинг кластера.

Остались вопросы?

Я - Компаниец Никита, менеджер компании Voxlink. Хотите уточнить детали или готовы оставить заявку? Укажите номер телефона, я перезвоню в течение 3-х секунд.

категории

- DECT

- Linux

- Вспомогательный софт при работе с Asterisk

- Интеграция с CRM и другими системами

- Интеграция с другими АТС

- Использование Elastix

- Использование FreePBX

- Книга

- Мониторинг и траблшутинг

- Настройка Asterisk

- Настройка IP-телефонов

- Настройка VoIP-оборудования

- Новости и Статьи

- Подключение операторов связи

- Разработка под Asterisk

- Установка Asterisk

VoIP оборудование

ближайшие курсы

Новые статьи

10 доводов в пользу Asterisk

Распространяется бесплатно.

Asterisk – программное обеспечение с открытым исходным кодом, распространяется по лицензии GPL. Следовательно, установив один раз Asterisk вам не придется дополнительно платить за новых абонентов, подключение новых транков, расширение функционала и прочие лицензии. Это приближает стоимость владения станцией к нулю.

Безопасен в использовании.

Любое программное обеспечение может стать объектом интереса злоумышленников, в том числе телефонная станция. Однако, сам Asterisk, а также операционная система, на которой он работает, дают множество инструментов защиты от любых атак. При грамотной настройке безопасности у злоумышленников нет никаких шансов попасть на станцию.

Надежен в эксплуатации.

Время работы серверов некоторых наших клиентов исчисляется годами. Это значит, что Asterisk работает несколько лет, ему не требуются никакие перезагрузки или принудительные отключения. А еще это говорит о том, что в районе отличная ситуация с электроэнергией, но это уже не заслуга Asterisk.

Гибкий в настройке.

Зачастую возможности Asterisk ограничивает только фантазия пользователя. Ни один конструктор шаблонов не сравнится с Asterisk по гибкости настройки. Это позволяет решать с помощью Asterisk любые бизнес задачи, даже те, в которых выбор в его пользу не кажется изначально очевидным.

Имеет огромный функционал.

Во многом именно Asterisk показал какой должна быть современная телефонная станция. За многие годы развития функциональность Asterisk расширилась, а все основные возможности по-прежнему доступны бесплатно сразу после установки.

Интегрируется с любыми системами.

То, что Asterisk не умеет сам, он позволяет реализовать за счет интеграции. Это могут быть интеграции с коммерческими телефонными станциями, CRM, ERP системами, биллингом, сервисами колл-трекинга, колл-бэка и модулями статистики и аналитики.

Позволяет телефонизировать офис за считанные часы.

В нашей практике были проекты, реализованные за один рабочий день. Это значит, что утром к нам обращался клиент, а уже через несколько часов он пользовался новой IP-АТС. Безусловно, такая скорость редкость, ведь АТС – инструмент зарабатывания денег для многих компаний и спешка во внедрении не уместна. Но в случае острой необходимости Asterisk готов к быстрому старту.

Отличная масштабируемость.

Очень утомительно постоянно возвращаться к одному и тому же вопросу. Такое часто бывает в случае некачественного исполнения работ или выбора заведомо неподходящего бизнес-решения. С Asterisk точно не будет такой проблемы! Телефонная станция, построенная на Asterisk может быть масштабируема до немыслимых размеров. Главное – правильно подобрать оборудование.

Повышает управляемость бизнеса.

Asterisk дает не просто набор полезных функций, он повышает управляемость организации, качества и комфортности управления, а также увеличивает прозрачность бизнеса для руководства. Достичь этого можно, например, за счет автоматизации отчетов, подключения бота в Telegram, санкционированного доступа к станции из любой точки мира.

Снижает расходы на связь.

Связь между внутренними абонентами IP-АТС бесплатна всегда, независимо от их географического расположения. Также к Asterisk можно подключить любых операторов телефонии, в том числе GSM сим-карты и настроить маршрутизацию вызовов по наиболее выгодному тарифу. Всё это позволяет экономить с первых минут пользования станцией.

База знаний

База знаний  IP-АТС

IP-АТС  Оборудование

Оборудование  О нас

О нас

Добрый день.

Как настроить кластер pacemakerбез общего хранилища — синхронизировать разделы диска sda3 на 3 нодах?

После создания кластера, помимо двух сетевых интерфейсов на каждой ноде было добавлено еще по 2 интерфейса и добавлено 2 виртуальных кластерных IP. Получилось так, что, например, SIP REGISTER приходит на кластерный IP, а ответ уходит с IP мастер-ноды. Как это исправить?